为什么你的 AI 编程总是失控?可能是缺少这个小步闭环策略

在 AI 辅助编程时代,问题往往不在于模型是否"会写代码",而在于开发者是否掌握了合适的协作方式。本文分享一套经过反复实践验证的「小步闭环」开发方法,目标是将 AI 从不可控的灵感来源,转变为稳定、可预期的工程协作者。

传统 AI 协作的三大痛点

在实际使用 AI 编程的过程中,开发者常会遇到以下典型问题:

- 功能偏离:修复一个 bug,反而引入多个新问题

- 上下文污染:对话过长后,AI 开始前后矛盾、自我否定

- 方向失控:一开始思路正确,最终却不得不整体推倒重来

这些现象通常并非模型能力不足,而是源于一个更本质的问题:

任务的组织方式并不符合 AI 的工作机制。

AI 友好的最小开发闭环

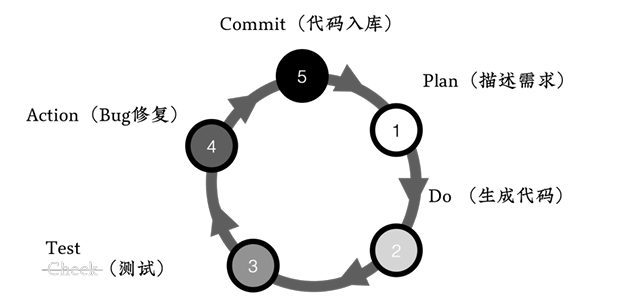

为此,可以采用一套更克制、更工程化的迭代流程:

需求描述 → 代码生成 → 测试创建 → Bug 修复 → 代码提交

这个闭环强调:一次只完成一个可提交的小功能,而不是在同一个对话中不断叠加新问题。

1. 需求描述(Plan)

- 用单一、明确的目标描述当前要实现的功能

- 避免同时引入多个约束或扩展方向

- 示例:

"请实现一个接收用户名并返回欢迎消息的函数"

2. 代码生成(Do)

- 仅生成满足当前需求的最小可用实现

- 主动避免提前优化、抽象或扩展未来功能

这一阶段的目标不是"写得漂亮",而是"刚好满足需求"。

3. 测试创建(Test)

- 在功能实现后,立即要求 AI 生成配套的自动化测试

- 示例:

"请为这个新功能创建⾃动化测试"

测试的作用不仅是验证正确性,也是在帮助 AI 明确"什么才算完成"。

4. Bug 修复(Action)

- 根据测试失败或实际运行结果进行修正

- 每次只处理一个清晰、可验证的问题

- 避免在修 bug 的同时引入新需求

5. 代码提交(Commit)

- 功能完成后立即提交到版本库

- 提交完成后,开启新的对话窗口处理下一个需求

不要在原有对话中"顺手再加一点"。

核心原则解析

原则一:单一任务聚焦

- 认知负载问题:当 AI 被迫并行处理多个目标时,推理链路容易相互干扰

- 最佳实践:

- 一个对话窗口只解决一个可提交的小问题

- 在功能完成前,不追加新的需求或想法

这并不是限制 AI 的能力,而是在避免不必要的推理冲突。

原则二:上下文窗口管理

- 长度陷阱:随着对话变长,早期约束和共识会逐渐被弱化甚至遗忘

- 控制策略:

- 单次对话严格限制在一个功能闭环内

- 完成即提交,提交即新建会话

短上下文,反而更容易得到稳定、一致的结果。

提交时机的工程意义

与传统开发相比,在 AI 协作场景中,"及时提交"具有更重要的工程价值:

- 强制收敛:迫使开发者判断功能是否真的完成

- 安全回退:为后续修改提供明确、稳定的锚点

- 认知重置:帮助人和 AI 一起摆脱旧上下文的干扰

一次提交,本质上是一次阶段性的"清空状态"。

实施建议

在实际落地过程中,可以参考以下建议:

- 任务拆分:将用户故事拆解为 15–30 分钟内可完成的微任务

- 会话纪律:严格遵循"完成即提交,提交即新建会话"的原则

- 测试驱动:每个功能都配套自动化测试,避免只验证"看起来能跑"

- 版本控制:提交信息中注明 "AI-assisted",并记录关键提示词版本

这些约束看似增加了流程,但实际会显著降低返工成本。

总结

在工程实践中,更合理的心态是:

将 AI 视为一个需要被流程保护的合作者。

- 它的优势在于:擅长短程、高专注度的问题

- 它的短板在于:不擅长多目标、长上下文的持续管理

可执行的行动指南:

- 使用原子化的任务拆分

- 严格执行小步闭环迭代

- 建立清晰、及时的提交纪律

通过这套方法,可以显著提升 AI 协作的确定性和工程效率,把原本不可控的"灵感输出",转化为可重复、可维护的工程实践。